入群一年多,这周才正式加入上海人工智能实验室旗下书生-浦语组织的大模型训练营课程,明天参加阿里云组织的AI相关的线下活动。

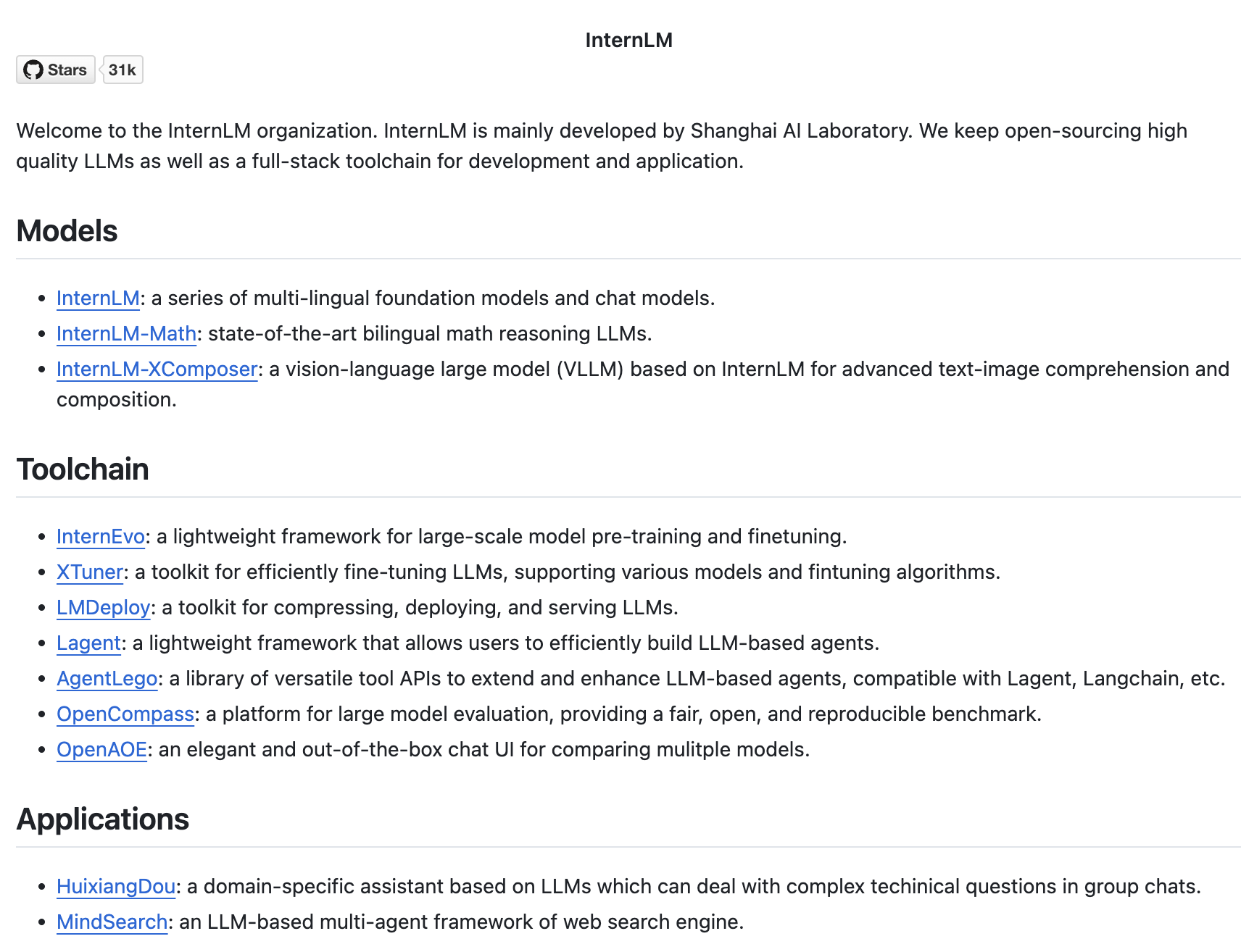

关于 InternLM:

感谢书生浦语的精心组织,不但提供了理论和实战的课程资料,还贴心地提供了免费的算力资源。第1天完成了入门阶别的4门课程和作业,非常期待后续的实战环节。

还在职的时候跟团队同学讲过我对AI的观点,对于所有的新事物,拥抱且去魅,不同的人对于web3、AI或其他新事物有着不同的态度:或抱以强烈的期待、或平和、或无视、或抗拒、或恐惧、或嗤之以鼻。当还身处工作之中的时候,自己也总是说没有那么多的时间去学习,现在终于有较多的时间去正视和打量它,我持有介于平和与期待之间的观点。

12月内的初步计划是将Multi Agent融入到自己的日常生活中,届时可能也以此作为课程结业的项目内容,同时更想为我的数字游民生活搭配若干AI小伙伴,与其远远地观望,不若游戏其中。或许明年游走各国的时候,还有许多无形的小助理陪着我。

以下内容取自学习过程中的一篇笔记:

概览

书生大模型全链路开源开放体系涵盖了开源模型研究、工程和应用环节,提供了一个全面的开源环境,包括模型、工具和资源,以支持大模型的开发、部署和应用。

InternLM 生态通过提供全面的开源工具和资源,支持大模型在多个领域的应用和发展。从基础的NLP任务到复杂的多模态学习和企业级应用,InternLM 生态都在积极推动大模型技术的创新和普及。通过这些工具和资源,开发者和研究人员可以更容易地构建、部署和优化自己的语言模型,以解决实际问题并推动技术进步。

InternLM之于学术、工程及应用

学术角度(研究与创新)

书生浦语大模型和InternLM体系提供了丰富的开源资源,包括预训练模型、训练代码和数据集,这为学术界提供了一个平台,以促进语言模型和人工智能领域的研究和创新。InternLM-XComposer-2.5等模型支持长上下文的输入和输出,为视觉语言模型的研究提供了新的视角,推动了多模态学习领域的发展。InternLM体系中的双语数学推理LLMs为跨语言和跨领域的研究提供了工具,促进了不同文化和学科之间的学术交流。LMDeploy等工具包的研究和开发,为模型压缩和优化领域提供了新的研究方向,有助于提高模型的效率和可扩展性。

工程角度(开发与部署)

InternLM体系提供了完整的工具链,包括模型训练、微调、压缩和部署工具,这使得工程师能够更高效地开发和部署大型语言模型。支持模型的微调和定制,使得工程师可以根据特定的业务需求调整模型,以实现最佳的性能。支持模型在不同平台上的部署,包括云端和边缘设备,这为工程师提供了更多的灵活性。

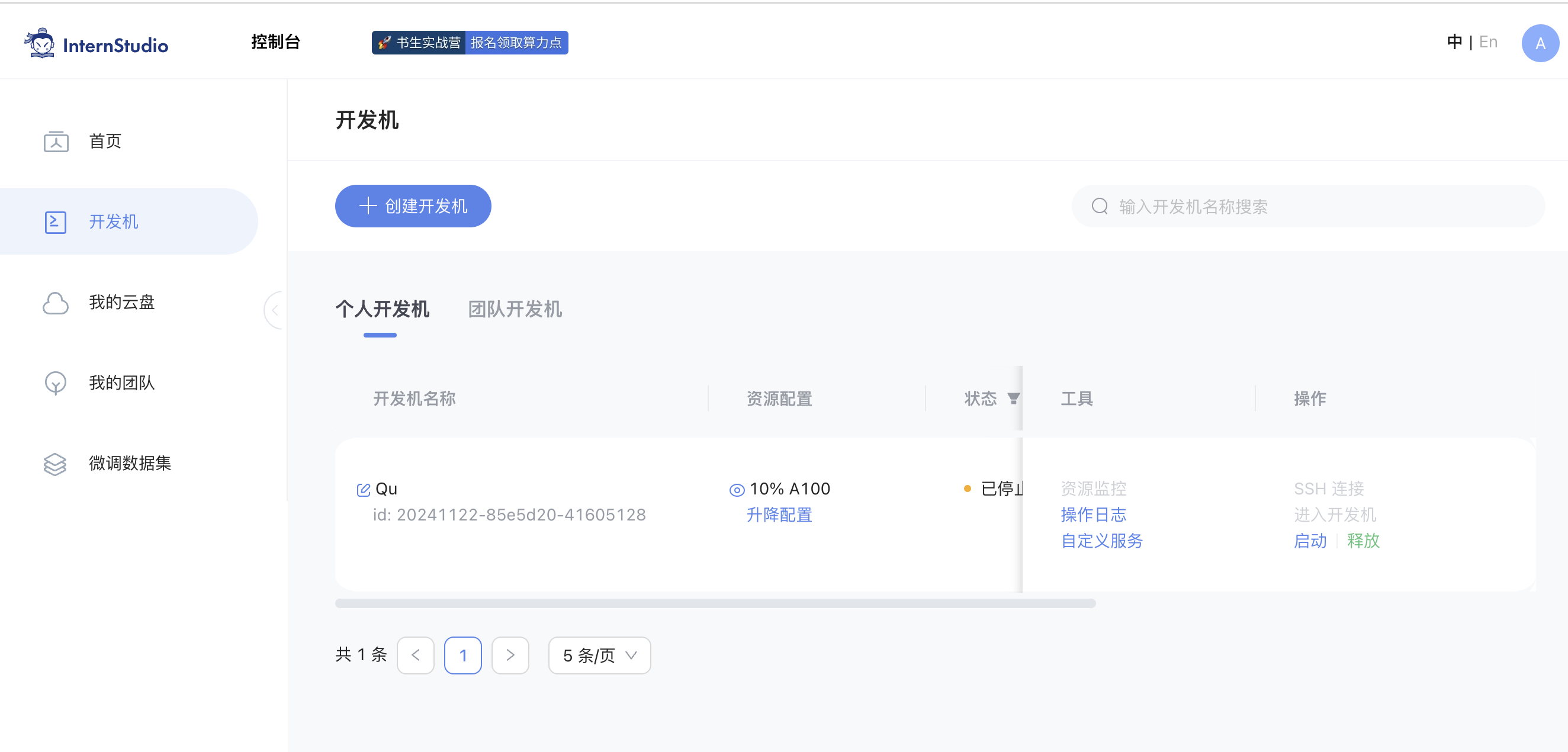

InternStudio算力平台为模型训练和实验提供了必要的计算资源,这对于资源有限的团队尤为重要。

应用角度

-

自然语言处理(NLP)应用:书生浦语大模型可以应用于文本分类、情感分析、机器翻译、问答系统等NLP任务,提高应用的智能化水平。

-

视觉语言应用:通过InternLM-XComposer-2.5等模型,可以在图像描述、视觉问答等视觉语言任务中实现更高级的应用。

-

搜索与推荐系统:基于LLM的多智能体框架可以用于构建更智能的搜索引擎和推荐系统,提供更个性化的服务。

-

教育与研究:书生浦语大模型和InternLM体系为教育和研究提供了工具和资源,支持教学和科研活动的开展。

-

企业解决方案:InternLM体系支持企业在客户服务、内容审核、市场分析等领域部署定制化的语言模型,提高业务效率和准确性。

-

多语言支持:InternLM体系中的双语和多语言模型为全球化企业提供了支持,帮助他们更好地服务不同语言的用户。

资源与工具

InternLM GitHub 仓库

-

InternLM2.5:官方发布了InternLM2.5的基础和聊天模型,支持1M上下文。

-

LMDeploy:提供用于压缩、部署和提供LLMs(大型语言模型)的工具包。

-

InternLM-XComposer-2.5:一个支持长上下文输入和输出的大型视觉语言模型。

-

Fine-tuning Toolkit:一个高效、灵活且功能齐全的微调工具包,用于微调LLM(如InternLM2, Llama3, Phi3, Qwen, Mistral等)。

-

Web Search Engine Framework:基于LLM的多智能体框架,用于构建网络搜索引擎(类似于Perplexity.ai Pro和SearchGPT)。

-

Bilingual Math Reasoning LLMs:最先进的双语开源数学推理LLMs。

书生·浦语社区资源

-

课程闯关任务:提供了一个课程闯关任务,帮助参与者逐步学习和掌握工具链的使用。

-

InternStudio 算力平台:提供了100算力点作为闯关激励,支持模型训练和部署。

-

书生大模型实战营:提供了一个实战营,参与者可以免费获取A100算力,进行模型训练和实践。

通过上述资源,用户可以深入了解书生大模型的架构和应用,同时利用提供的算力平台进行实际的模型训练和部署。这些资源为研究人员和开发者提供了一个完整的生态系统,以促进大模型技术的发展和应用。

大模型各领域关联覆盖情况

InternLM 提供了多种NLP模型,如InternLM2.5,这些模型可以处理语言理解和生成任务,包括文本分类、情感分析、机器翻译、问答系统等。通过InternLM-XComposer-2.5,支持视觉语言任务,如图像描述、视觉问答和多模态内容理解。Web Search Engine Framework提供了构建类似Perplexity.ai Pro和SearchGPT的搜索引擎的基础,这些搜索引擎可以利用LLMs提供更智能的搜索结果和推荐。

通过InternLM提供的开源资源和算力平台,教育工作者和研究人员可以在数学推理、科学问题解答等领域进行研究和教学。同时支持企业在客户服务、内容审核、市场分析等领域部署定制化的语言模型,以提高效率和准确性。

对于模型压缩与优化,LMDeploy工具包专注于模型压缩和优化,使得大型模型可以更高效地部署在资源受限的环境中。而对微调和定制,InternLM 提供的微调工具包允许用户根据自己的特定需求定制和微调模型,以适应特定的业务场景。同时,InternStudio 算力平台为模型训练和实验提供了必要的计算资源,对于没有足够硬件资源的个人和团队来说也提供了很给力的支持。

结论

书生浦语大模型和InternLM体系从学术、工程到应用层面提供了全方位的支持。它们不仅推动了人工智能领域的研究和创新,还为工程师提供了强大的工具链,以及为实际应用提供了广泛的解决方案。通过这些资源和工具,学术界、工业界和企业可以共同推动大型语言模型技术的发展和应用。参与者可以通过上述链接深入了解和参与到这个生态系统中,共同推动人工智能技术的发展。